O Ισραηλινός ιστορικός, φιλόσοφος και συγγραφέας, Γιουβάλ Νόα Χαράρι με πρόσφατο άρθρο του στο περιοδικό The Economist έθεσε στο διεθνή δημόσιο διάλογο ενδιαφέροντες προβληματισμούς για την Τεχνητή Νοημοσύνη και τις επιδράσεις της ανάπτυξής της στον ανθρώπινο πολιτισμό ή στην «ακύρωσή» του (τουλάχιστον με την έννοια που τον γνωρίζουμε σήμερα).

Όπως επισημαίνει, από το 1945 γνωρίζουμε ότι η πυρηνική τεχνολογία θα μπορούσε να παράγει φθηνή ενέργεια προς όφελος των ανθρώπων αλλά και πως θα μπορούσε επίσης να καταστρέψει τον ανθρώπινο πολιτισμό. Αναμορφώσαμε, όπως αναφέρει, τη διεθνή τάξη για να προστατεύσουμε την ανθρωπότητα και να διασφαλίσουμε ότι η πυρηνική τεχνολογία θα χρησιμοποιηθεί κυρίως για καλό. Τώρα, όμως, «θα πρέπει να παλέψουμε με ένα νέο όπλο μαζικής καταστροφής που μπορεί να εκμηδενίσει τον ψυχικό και κοινωνικό μας κόσμο».

Σε ό,τι αφορά την Τεχνητή Νοημοσύνη και την ανάπτυξη των εφαρμογών της ο Χαράρι δεν θίγει απλά την ορθή ή την επιβλαβή χρήση της. Διακρίνει μία καινοτόμα παράμετρο με διαφαινόμενες σαρωτικές επιπτώσεις για τον ανθρώπινο πολιτισμό: Προηγούμενες ανθρώπινες εφευρέσεις όπως το τυπογραφείο και το ραδιόφωνο βοήθησαν στη διάδοση των ανθρώπινων πολιτιστικών ιδεών, αλλά ποτέ δεν δημιούργησαν νέες δικές τους πολιτιστικές ιδέες. «Η τεχνητή νοημοσύνη είναι κάτι θεμελιωδώς διαφορετικό. Μπορεί να δημιουργήσει εντελώς νέες ιδέες, εντελώς νέα κουλτούρα».

Από την άλλη, βάζει στο τραπέζι του διεθνούς δημόσιου διαλόγου και μία άλλη «ειδοποιό» διαφορά σε σχέση με ο,τιδήποτε δημιούργησε ο άνθρωπος στο παρελθόν. Όπως αναφέρει, τα τελευταία δύο χρόνια έχουν εμφανιστεί νέα εργαλεία τεχνητής νοημοσύνης που απειλούν την επιβίωση του ανθρώπινου πολιτισμού από μια απροσδόκητη κατεύθυνση. Η Τεχνητή Νοημοσύνη έχει αποκτήσει μερικές αξιοσημείωτες ικανότητες χειρισμού και δημιουργίας γλώσσας, είτε με λέξεις, ήχους ή εικόνες. «Με τον τρόπο αυτόν έχει χακάρει το λειτουργικό σύστημα του πολιτισμού μας».

Αναρωτιέται έτσι τι θα συνέβαινε όταν μια μη ανθρώπινη νοημοσύνη γίνει καλύτερη από τον μέσο άνθρωπο στο να λέει ιστορίες, να συνθέτει μελωδίες, να σχεδιάζει εικόνες και να γράφει νόμους και γραφές;

Προχωρώντας τη σκέψη φαντάζεται μία (όχι μακρινή, ούτε απίθανη) ανθρώπινη κοινωνία στην οποία μία Τ.Ν. αντιπαλεύει με μία άλλη Τ.Ν. προσποιούμενες αμφότερες τις στενές σχέσεις με εμάς ώστε στη συνέχεια να χρησιμοποιηθούν για να μας πείσουν να ψηφίσουμε συγκεκριμένους πολιτικούς ή να αγοράσουμε συγκεκριμένα προϊόντα.

Ο Χαράρι εκτιμά πως από τώρα οι βιομηχανίες ειδήσεων και διαφήμισης θα πρέπει να τρομοκρατούνται. Όπως αναφέρει χαρακτηριστικά «γιατί να διαβάζω μια εφημερίδα όταν μπορώ απλώς να ζητήσω τον χρησμό του μαντείου για να μάθω τα τελευταία νέα; Και ποιος είναι ο σκοπός των διαφημίσεων, όταν μπορώ απλώς να ζητήσω από το μαντείο να μου πει τι να αγοράσω;»

Όπως σημειώνει, τα νέα εργαλεία τεχνητής νοημοσύνης θα είχαν τεράστια επιρροή στις απόψεις και τις κοσμοθεωρίες μας, αφού μπορεί να φτάσουμε στο σημείο να χρησιμοποιούμε έναν και μόνο σύμβουλο τεχνητής νοημοσύνης σαν «μαντείο-παντογνώστη».

To μαντείο-παντογνώστης

Κάποιοι από εμάς ήδη δοκιμάσαμε το ChatGPT και πήραμε μία «γεύση» από το «μαντείο». Αν και εγώ παραμένω στην πλευρά των πιο δύσπιστων και των ελάχιστα «γοητευμένων» από τις απαντήσεις ή καλύτερα τις υπεκφυγές του ChatGPT, δεν κατάφερα να μην σαστίσω με την ταχύτητα αντίδρασής του. Υπάρχουν περιπτώσεις που η ταχύτητα αντίδρασης αποβαίνει όχι απλά κρίσιμη για την εξέλιξη μίας υπόθεσης αλλά και για την εξέλιξη ακόμη και της ίδιας της ζωής (σε περίπτωση κινδύνου). Είμαστε άραγε ήδη «χαμένοι από χέρι»;

Ο ίδιος θεωρεί πως αυτό για το οποίο μιλάμε είναι δυνητικά το τέλος της ανθρώπινης ιστορίας. «Όχι το τέλος της ιστορίας, απλώς το τέλος του ανθρωποκυριαρχούμενου μέρους της. Η ιστορία είναι η αλληλεπίδραση μεταξύ βιολογίας και πολιτισμού. Ανάμεσα στις βιολογικές μας ανάγκες και επιθυμίες για πράγματα όπως το φαγητό και το σεξ, και τις πολιτιστικές μας δημιουργίες όπως οι θρησκείες και οι νόμοι. Η ιστορία είναι η διαδικασία μέσω της οποίας νόμοι και θρησκείες διαμορφώνουν το φαγητό και το σεξ» αναφέρει χαρακτηριστικά…

Σε κάθε περίπτωση, ίσως να έχουμε ακόμη χρόνο ώστε να μη χάσουμε εντελώς την κούρσα με την Τεχνητή Νοημοσύνη και να μπορούμε να θεσπίσουμε από τώρα κάποιους βασικούς κανόνες όχι μόνον για την χρήση αλλά και την εξέλιξή της. Να θέσουμε δηλαδή συγκεκριμένα «όρια».

Κρούοντας τον κώδωνα κινδύνου

Άλλωστε ήδη σήμερα υπάρχουν αρκετοί από τους ειδικούς που τρομάζουν με αυτό που έχουν ήδη διαπιστώσει οι ίδιοι από τις σημερινές και μεσοπρόθεσμες ικανότητες των εφαρμοτών της Τ.Ν.

Και δεν είναι μόνον ο δισεκατομμυριούχος πολυπράγμων Ίλον Μασκ που τον περασμένο Μάρτιο έβαλε την υπογραφή του μαζί με άλλους 200 ειδικούς σε κοινή επιστολή που εκδόθηκε από το μη κερδοσκοπικό Ινστιτούτο «Future of Life Institute» προειδοποιώντας για τους «σοβαρότατους κινδύνους για την κοινωνία και την ανθρωπότητα», αν επιτραπεί η εξέλιξή τους χωρίς επαρκείς διασφαλίσεις».

Πριν μερικές βδομάδες είχαμε έκθεση της αμερικανικής τράπεζας Goldman Sachs αλλά και του «Διεθνούς Οικονομικού Φόρουμ του Νταβός» που προέβλεπαν την απώλεια δεκάδων εκατομμυρίων θέσεων εργασίας και την αντικατάστασή τους από την Τ.Ν.

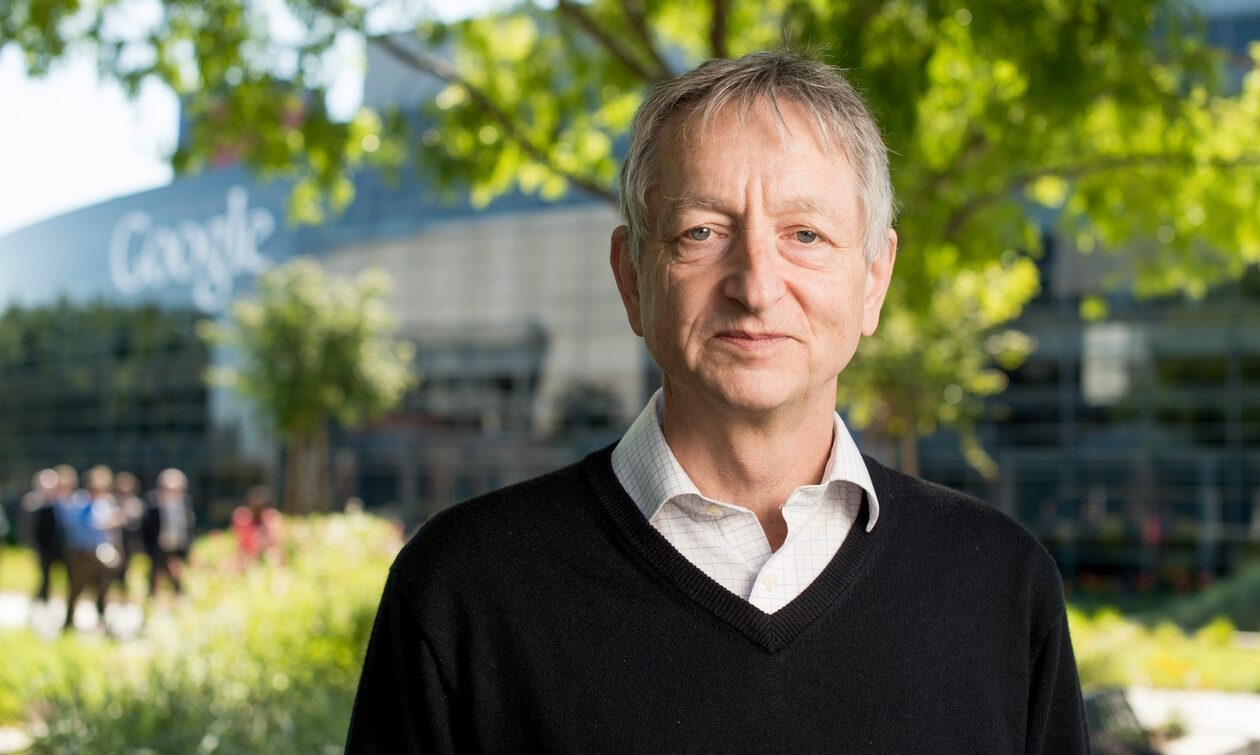

Ο Τζέφρι Εβερεστ Χίντον, γνωστός και σαν «νονός της ΑΙ» που γεννήθηκε το 1947 στο Γουίμπλεντον του Λονδίνου, παραιτήθηκε στο τέλος του περασμένου Απρίλη εκφράζοντας αγωνία για τους εντεινόμενους κινδύνους από τις εφαρμογές της Τ.Ν. Σε δήλωσή του στους Τάιμς της Ν.Υόρκης δεν έκρυψε ότι «μετανιώνει» για τη δουλειά του βρίσκοντας «αρκετά τρομακτικούς» τους κινδύνους από την χρήση των chatbots Τ.Ν. «Αυτή τη στιγμή δεν είναι πιο έξυπνα από μας, αυτό μπορώ να το πω. Νομίζω όμως ότι σύντομα μπορεί να γίνουν» ανέφερε τότε.

Στο άρθρο των New York Times, ο Δρ Χίντον αναφέρθηκε σε «αρνητικούς παράγοντες» που θα προσπαθούσαν να χρησιμοποιήσουν την τεχνητή νοημοσύνη για «δυσάρεστα πράγματα». Διέκρινε «αρνητικούς παράγοντες» που θα προσπαθούσαν να χρησιμοποιήσουν την τεχνητή νοημοσύνη για «δυσάρεστα πράγματα», επισημαίνοντας:

«Έχω καταλήξει στο συμπέρασμα ότι το είδος της νοημοσύνης που αναπτύσσουμε είναι πολύ διαφορετικό από τη νοημοσύνη που έχουμε. Είμαστε βιολογικά συστήματα και αυτά είναι ψηφιακά συστήματα. Και η μεγάλη διαφορά είναι ότι με τα ψηφιακά συστήματα, υπάρχουν πολλά αντίγραφα του ίδιου συνόλου βαρών, του ίδιου μοντέλου. Και όλα αυτά τα αντίγραφα μπορούν να μάθουν χωριστά, αλλά να μοιράζονται τις γνώσεις τους αμέσως. Έτσι είναι σαν να είχατε 10.000 άτομα και όποτε ένα άτομο μάθαινε κάτι, όλοι το γνώριζαν αυτόματα. Και έτσι αυτά τα chatbots μπορούν να γνωρίζουν πολύ περισσότερα από οποιοδήποτε άτομο».

Πριν περίπου έναν χρόνο, τον Ιούνιο του 2022, ο μηχανικός της Google Μπλέικ Λεμόιν δουλεύοντας πάνω στο πρόγραμμα Τ.Ν.Lamda υποστήριξε πως διαπίστωσε την ανάπτυξη «ενσυνείδησης».

Ο Λεμόιν, που εργάζεται για τον οργανισμό Responsible AI («υπεύθυνης τεχνητής νοημοσύνης») της Google, άρχισε να συνομιλεί με το LaMDA ως μέρος της δουλειάς του το περασμένο φθινόπωρο. Αποστολή του ήταν να ελέγξει εάν το πρόγραμμα χρησιμοποιεί λέξεις ή φράσεις που θα μπορούσαν να μπουν υπό την ομπρέλα της ρητορικής μίσους και διακρίσεων.

Καθώς μιλούσε στο LaMDA για θέματα όπως η θρησκεία, ο Λεμόιν παρατήρησε ότι το chatbot άρχισε να του μιλά για τα δικά του δικαιώματα και για την «προσωπικότητά» του. Σύντομα, κατέληξαν να συνομιλούν για τους νόμους της ρομποτικής του Ισαάκ Ασίμωφ με το chatbot να επιχειρηματολογεί υπέρ του τρίτου νόμου κατά τον οποίο «ένα ρομπότ πρέπει να προστατεύει την ίδια του την ύπαρξη…».

Εντυπωσιασμένος, ο Λεμόιν παρουσίασε στοιχεία στους προϊσταμένους του στην Google που κατά την άποψή του αποδείκνυαν ότι το LaMDA έχει συνείδηση. Οι ισχυρισμοί του απορρίφθηκαν από την επικεφαλής της «Responsible AI» Τζεν Γκενάι και από τον αντιπρόεδρο της Google, Μπλέιζ Αγουέρα Άρκας.

Πρόσφατα, συντάκτης του BBC, εκτιμούσε πως αυτή την περίοδο «βρισκόμαστε σε ένα τρένο που κινείται με ταχύτητα και υπάρχει ανησυχία ότι μια μέρα θα αρχίσει να χτίζει τις δικές του γραμμές».

Έχουμε άραγε χάσει το «τρένο» ελέγχου της Τ.Ν.;

Προς το παρόν μάλλον όχι.

Η προσπάθεια στην ΕΕ για ρυθμιστικό πλαίσιο

Από την άλλη, μετά από τόσες προειδοποιήσεις επιχειρεί κάποιος να βάλει κάποιους κανόνες στο «παιχνίδι»;

Μπορεί κανείς να κατηγορεί την Ευρωπαϊκή Ένωση για πάρα πολλά πράγματα, ωστόσο, στον τομέα της Τ.Ν. δείχνει να κάνει κάποια βήματα προς την κατεύθυνση θέσπισης ενός ρυθμιστικού πλαισίου μολονότι είναι ουραγός στην κούρσα του ανταγωνισμού με τις ΗΠΑ και την Κίνα.

Στις 11 Μαΐου 2023, οι ευρωβουλευτές έδωσαν το «πράσινο φως» στο πρώτο ευρωπαϊκό σχέδιο για την κανονιστική ρύθμιση της ΤΝ, που επιχειρήθηκε να συνταχτεί τον Απρίλιο του 2021, ώστε να επιβληθούν κάποιες «νέες απαγορεύσεις». Η ΕΕ έδειξε πως θέλει να είναι η πρώτη παγκοσμίως που θα αποκτήσει «πλήρες» νομικό πλαίσιο για να περιορίσει τις παρεκτροπές της τεχνητής νοημοσύνης, διασφαλίζοντας παράλληλα την καινοτομία. Ωστόσο, η εμφάνιση του ChatGPT και ο διεθνής δημόσιος διάλογος που προκάλεσε από τον Νοέμβριο του 2022 για τις σημερινές δυνατότητες της ΤΝ καθυστέρησε την εξέλιξη του φιλόδοξου σχεδίου κανονιστικής ρύθμισης λόγω σφοδρών αντιπαραθέσεων εν σχέση με τους πιθανούς κινδύνους από την Αναγεννητική Τεχνητή Νοημοσύνη («generative artificial intelligence»).

Τα κράτη μέλη της ΕΕ καθόρισαν τη θέση τους μόλις στα τέλη του 2022 μετά από περίπου 3.000 τροποποιήσεις. Στα μέσα Ιουνίου θα πρέπει να επικυρωθεί από την ολομέλεια του ευρωκοινοβουλίου ώστε να αρχίσει στη συνέχεια μια δύσκολη διαπραγμάτευση μεταξύ των 27 χωρών-μελών, του ευρωκοινοβουλίου και της Ευρωπαϊκής Επιτροπής. Οι διαβουλεύσεις που θα γίνουν αναμένεται να οδηγήσουν σε ένα τελικό προσχέδιο συμφωνίας στο τέλος του 2023 ή στις αρχές του 2024 και να αρχίσει να εφαρμόζεται γύρω στο 2026 αφού προηγηθεί μία διετής περίοδος χάριτος.

Τι προβλέπει όμως το προσχέδιο ρυθμιστικού πλαισίου για την ΤΝ;

Σε γενικές γραμμές, προβλέπει μια πλαισίωση των συστημάτων Τεχνητής Νοημοσύνης που αλληλεπιδρούν με τους ανθρώπους.

- Θα τα υποχρεώσει να ενημερώνουν τον χρήστη πως έχει να κάνει με μια μηχανή και θα αναγκάσει τις εφαρμογές, που δημιουργούν εικόνες, να διευκρινίζουν πως αυτές έχουν δημιουργηθεί τεχνητά.

- Οι απαγορεύσεις θα είναι σπάνιες. Θα αφορούν τις εφαρμογές που είναι αντίθετες στις ευρωπαϊκές αξίες, όπως τα συστήματα μαζικής επιτήρησης που χρησιμοποιούνται στην Κίνα.

- Οι ευρωβουλευτές θέλουν να προσθέσουν σ’ αυτές την απαγόρευση συστημάτων αναγνώρισης συναισθημάτων και να καταργήσουν τις εξαιρέσεις που επιτρέπουν τη βιομετρική ταυτοποίηση εξ αποστάσεως ανθρώπων σε δημόσιους χώρους από τις δυνάμεις της τάξης.

- Θέλουν επίσης να απαγορεύσουν τη μαζική συγκομιδή φωτογραφιών από το Ιντερνετ για την εκπαίδευση των αλγορίθμων χωρίς τη συμφωνία των ενδιαφερόμενων προσώπων.

- Οι παραβάτες θα κληθούν να πληρώσουν πρόστιμα έως 30 εκατ. ευρώ (33 εκατ. δολάρια) ή το 6% των ετήσιων εσόδων εφόσον μιλάμε για πολυεθνικούς τεχνολογικούς κολοσσούς όπως οι εταιρίες Google, Microsoft, Apple.

Μένει βεβαίως να δούμε τι από όλα αυτά θα ισχύσει, πότε θα αρχίσει να εφαρμόζεται και εάν θα καταφέρει η ΕΕ να προλάβει τις εξελίξεις προτού αυτές καταστούν μοιραίες.

Προσδεθείτε! Η συνέχεια έχει ενδιαφέρον και ακόμη περισσότερες εκπλήξεις!

πηγη: https://kosmodromio.gr